目次

-

エグゼクティブサマリー

-

なぜAIにはデータインテリジェンスが必要か

-

新しいAI時代

-

モダンアーキテクチャ

-

デプロイメントの簡素化

-

AI実装の加速

エグゼクティブサマリー

AIが競争優位を決定する時代において、DDN Infiniaは単なる課題解決にとどまらず、実現可能性を再定義する変革的データプラットフォームとして登場します。NVIDIAやxAIとの共同設計により、Infiniaは漸進的な進歩ではなく、効率性とワークロード性能の大幅な向上を実現し、複雑さを低減してAIから実質的なビジネス価値を引き出します。これは、今日の最大規模のハイパースケーラーに匹敵するスケールでデータを活用する準備が整った組織向けのソリューションです。

ビジネスリーダーは、AI投資の最大化とコストや遅延の回避というプレッシャーに直面しています。Infiniaはこれらの課題に直接対処します。メタデータ駆動型のアーキテクチャにより、コア・クラウド・エッジに分散されたデータを統合し、インフラのボトルネックを排除、GPU利用率を最適化、運用コストを削減し、AIによるイノベーションを加速します。Infiniaは単なる追随ではなく、AIの提供価値の新しい基準を打ち立てます。

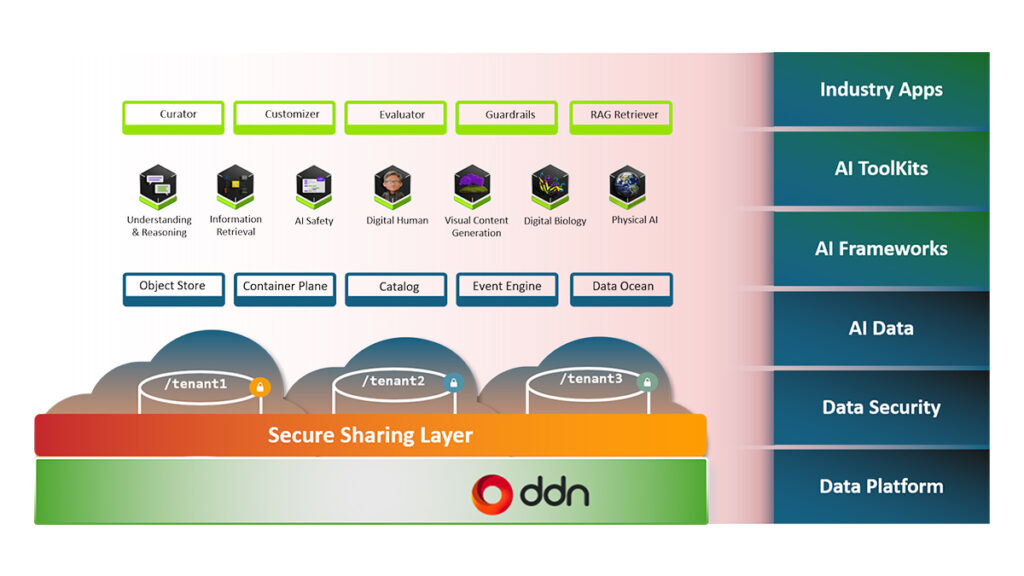

さらにInfiniaはインフラにとどまらず、スタック全体の上位に進出しています。クラウドネイティブかつソフトウェア定義型のデータインテリジェンスプラットフォームとして、AI実行エンジン、データオーケストレーションツール、開発者ワークフローをシームレスに接続。オブジェクト・ファイル・ブロックストレージへのネイティブアクセスをサポートし、Spark、TensorFlow、RayなどのAIフレームワークと直接統合します。強力なイベントエンジンと分散SQLクエリサービスにより、リアルタイムの自動化、インテリジェントなインデックス作成、スケールした推論を実現し、データ集約型パイプラインに構造・コンテキスト・高速性をもたらします。

AIを推進する企業にとって、Infiniaは停滞と支配力の違いを生む存在です。市場シェアを失い、活用されないデータは膨大な損失につながります。Infiniaは野心を圧倒的なリターンに変え、運用効率、具体的なビジネス成果、AI主導の企業としてリードする明確な道を提供します。

なぜAIにはデータインテリジェンスが必要か

AIは産業を変革する可能性がありますが、データインテリジェンスがなければ高コストで維持困難であり、真の力を発揮できません。組織は数十年にわたり、大量のマルチモーダルデータ(構造化・非構造化)を収集してきましたが、それらは物理的に分散し、複数のアプリケーションやハイブリッドクラウド環境、エッジにも散在しています。重要なのは、データを持つことではなく、「AI速度とスケールで活用可能にすること」です。

AIモデルは適切なデータへの高速アクセスを必要としますが、従来のデータ管理方法では複雑性、性能要求、コスト、安全性リスクに対応できません。データインテリジェンスは、メタデータを活用して重要情報に迅速にアクセスし、AIワークフローを効率化、インフラを最適化し、重要データへのスムーズでスケーラブルなアクセスを実現します。

AIの進展を妨げる4つの課題

-

複雑性:AIワークフローはクラウド・データセンター・エッジに分散する多様なデータセットを扱います。形式やセキュリティ規則、処理要件が異なり、既存ツールや断片化されたAIツールがさらに複雑さを増します。

-

性能:GPU利用率の低下やトレーニング遅延、リアルタイム推論の遅れなど、高レイテンシがAI成功の妨げになります。

-

コスト:コンピュートだけでなく電力、ストレージ、クラウドエグレスなどAIの総コストが急増。効率化がROI達成の鍵です。

-

安全かつ信頼性のあるスケーラビリティ:AIはスムーズなスケールとセキュリティ確保が必要。レガシーアーキテクチャはこれに対応できず、データサイロやガバナンスのギャップ、リスク増大を招きます。

レガシーインフラが追いつかない理由

従来のストレージアーキテクチャはAI向けには性能不足で、ボトルネックや高電力コスト、複雑さを生みます。LLMやマルチモーダルモデルの普及により、組織は単にスケーラブルで高速なだけでなく、革新的なAIを可能にするプラットフォームに移行する必要があります。

新しいAI時代のデータインテリジェンスプラットフォーム

DDN Infiniaはこのギャップを埋めるために設計されました。NVIDIAおよびxAIとの共同設計により、AIの性能・スケーラビリティ・効率性要求に応える次世代データインテリジェンスプラットフォームです。

-

メタデータ駆動型で極低レイテンシを実現

-

構造化・非構造化データをマルチクラウド、オンプレ、エッジで統合

-

AIワークフローを簡素化し、データを安全に保護

-

従来のストレージモデルを置き換え、サブミリ秒の低レイテンシでデータパイプラインを高速化

複雑性の低減

-

統合AIデータファブリック:マルチモーダルデータをクラウド・エッジ・コアで統合

-

シームレス統合:データ変換不要で即座に利用可能

-

ワンプラットフォームでAI:分析・準備・モデル読み込み・推論を中央管理

イノベーションの加速

-

GenAI & LLM:トレーニング・デプロイ時間を短縮

-

GPU最適化:データ移動を最小化してGPU利用率を最大化

-

リアルタイムAI:低レイテンシ推論を実現

コスト削減

-

10倍データ削減:メタデータ駆動でデータ移動・エグレスを最小化

-

電力削減:大規模運用でも消費電力を抑制

信頼性とセキュリティ

-

NVIDIA & xAIで検証済み:小規模から大規模まで拡張可能

-

セキュリティ重視:マルチテナント、暗号化、フォールトドメイン対応

-

100%ソフトウェア定義:X86、ARM、コンテナ、クラウドなど多様な環境に対応

モダンアーキテクチャ

-

クラウドネイティブ、コンテナ化、ソフトウェア定義型

-

AI実行エンジン、ストレージ、データアクセラレーションライブラリをシームレスに統合

-

ネイティブデータアクセス:オブジェクト、ファイル、ブロックストレージをサポート

-

AIフレームワーク統合:Spark、TensorFlow、PyTorch、Ray、MosaicML

-

メタデータ駆動型AIワークフロー:リアルタイムタグ付け、スケーラブルなメタデータ管理

マルチテナント & リソース最適化

-

動的SLA管理:優先度の高いワークロードにリソース保証

-

リソース分離:ユーザー間で安定したパフォーマンスを保証

-

弾力的スケーリング:数TBからエクサバイト規模まで対応

InfiniaのData Ocean & KVキャッシュ

-

高効率データ削減:常時圧縮とワイドストライプ消去符号

-

大規模スケーラビリティ:エクサバイト級まで対応

-

分散SQLサービス:部分データの高速クエリ

-

KVキャッシュ:Transformerモデルのトークン生成を高速化、GPU待機時間を削減

Infiniaイベントエンジン & 分析アクセラレータ

-

イベント駆動型自動化:リアルタイムのデータ操作をトリガー

-

メタデータ自動タグ付け・更新

-

SDKによるAPIアクセス:開発者がストレージ詳細を意識せずに利用可能

セキュリティと耐障害性

-

ゼロトラストアクセス制御

-

暗号化(転送中・保存時)

-

監査ログ

-

99.999%稼働率

-

フォールトドメイン対応のデータ保護

-

マルチテナントAIワークロードの安定性

デプロイの簡素化

-

小規模PoCから大規模マルチペタバイトまで対応

-

ノード追加・削除が動的に可能

-

ポリシーベースのデータ配置と耐障害機能

AI実装の加速

-

初回AIモデルの迅速な立ち上げ

-

Petabyte規模の本番データ対応

-

DDN IndustrySync:金融、ライフサイエンス、自動運転向け業界特化ソリューション

-

DDN Inferno:推論フェーズの加速、GPU利用率99%、サブミリ秒応答、AWS S3比12倍効率

これにより、AI実装の時間短縮とROI向上を実現。

公開日時